Page 8 - 智慧邊緣運算實現更環保、更安全與高效的社會

P. 8

6

SPOTLIGHT

·選擇模型:選擇一個符合應 用類型和性能要求(影像分類、物 件檢測、語音辨識和異常檢測等) 的模型;

至四分之一,而且還可以加快權重 資料從主記憶體到本地運算引擎 的傳輸。機器學習加速器通常具有 大容量本地記憶體,可儲存權重, 因而有利於減少主記憶體和本地 記憶體之間的資料傳輸;

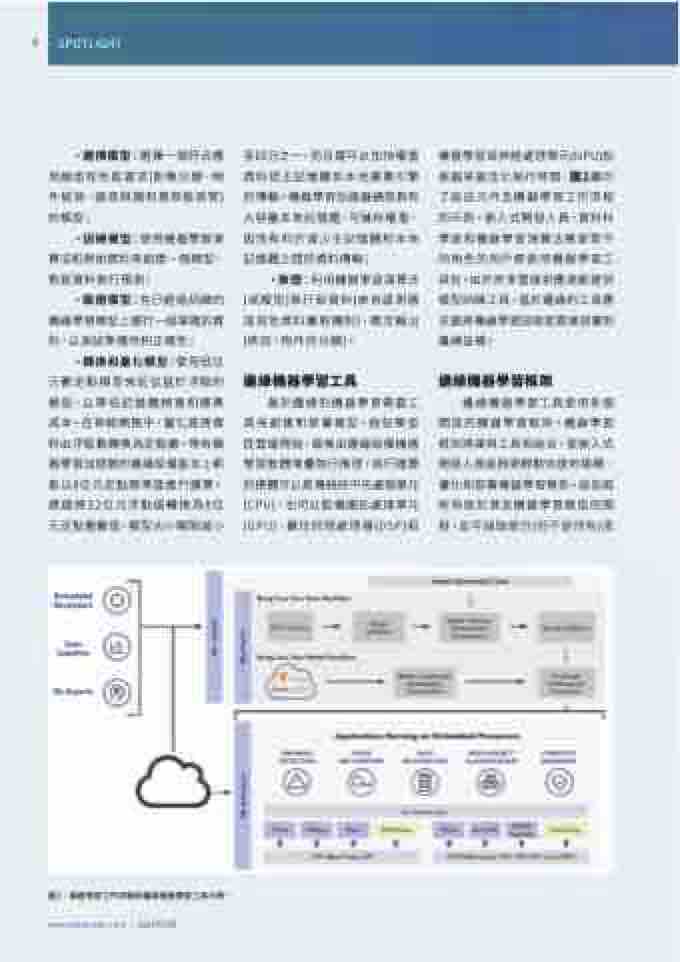

機器學習或神經處理單元(NPU)加 速器來最佳化執行時間,圖2顯示 了這些元件及機器學習工作流程 的示例。嵌入式開發人員、資料科 學家和機器學習演算法專家等不 同角色的用戶都使用機器學習工 具包。由於許多雲端供應商都提供 模型訓練工具,基於邊緣的工具應 支援將機器學習技術從雲端部署到 邊緣設備。

邊緣機器學習工具使用多個 開放的機器學習框架。機器學習 框架將庫與工具相結合,使嵌入式 開發人員能夠更輕鬆快速地建構、 優化和部署機器學習模型。這些框 架有助於普及機器學習模型的開 發,並可抽取部分(但不是所有)底

·訓練模型:使用機器學習演 算法和原始資料來創建一個模型, 對新資料執行預測;

·推理:利用機器學習演算法 (或模型)執行新資料(來自感測器 或其他資料獲取機制),確定輸出 (例如,物件的分類)。

·驗證模型:在已經過訓練的 機器學習模型上運行一組單獨的資 料,以測試準確性和正確性;

·轉換和量化模型:使用低位 元數定點模型來近似基於浮點的 模型,以降低記憶體頻寬和運算 成本。在神經網路中,量化是將資 料由浮點數轉換為定點數。帶有機 器學習加速器的邊緣設備基本上都 能以8位元定點精準度進行運算。 透過將32位元浮點值轉換為8位 元定點整數值,模型大小瞬間減小

邊緣機器學習工具

邊緣機器學習框架

基於邊緣的機器學習需要工 具來創建和部署模型,這些模型 從雲端開始,最後由邊緣設備機器 學習軟體堆疊執行推理。執行運算 的硬體可以是傳統的中央處理單元 (CPU),也可以配備圖形處理單元 (GPU)、數位訊號處理器(DSP)和

圖2:機器學習工作流程與邊緣機器學習工具示例。

www.eettaiwan.com | 2022年5月