Page 10 - 智慧邊緣運算實現更環保、更安全與高效的社會

P. 10

8

SPOTLIGHT

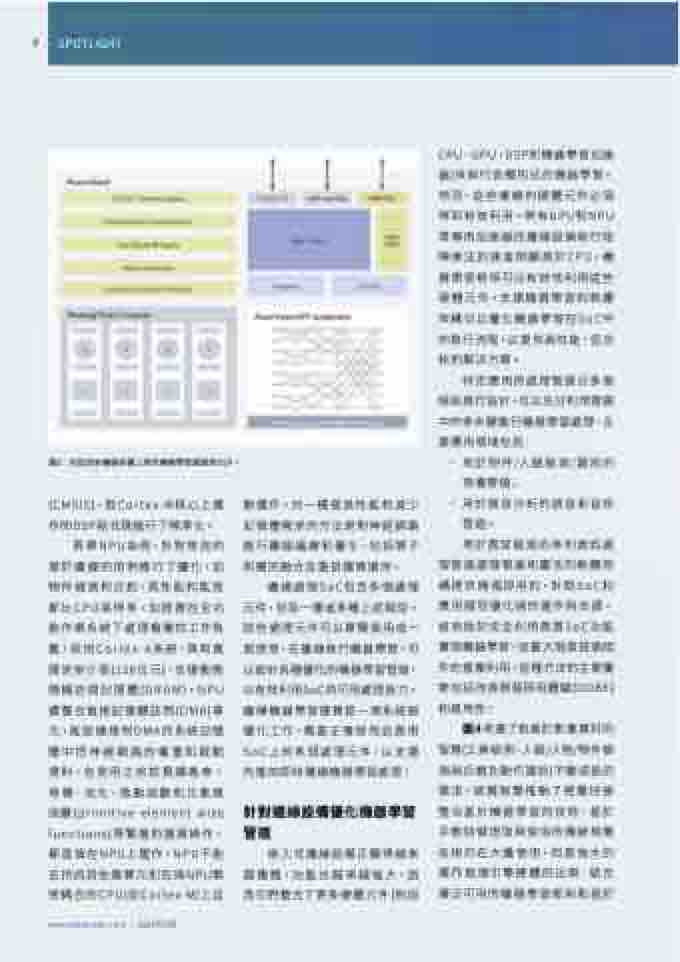

圖3:在低成本邊緣設備上用於機器學習運算的DSP。

再舉NPU為例,針對常見的 基於邊緣的用例進行了優化,如 物件檢測和分割,其性能和能效 都比CPU高得多。加速器在全功 能作業系統下處理複雜的工作負 載,採用Cortex-A系統,具有寬 匯流排介面(128位元),支援動態 隨機訪問記憶體(DRAM)。NPU 還整合直接記憶體訪問(DMA)單 元,能從連接到DMA的系統記憶 體中把神經網路的權重和啟動 資料,在使用之前就預讀進來。 卷積、池化、啟動函數和元素級 函數(primitive element wise functions)等繁重的運算操作, 都直接在NPU上運作,NPU不能 支持的其他運算元則在與NPU緊 密耦合的CPU(如Cortex-M)上自

www.eettaiwan.com | 2022年5月

• 用於物件/人臉檢測/識別的 視覺管道;

(CMSIS),對Cortex-M核心上運 作的DSP程式碼進行了標準化。

動運作。另一種提高性能和減少 記憶體需求的方法是對神經網路 進行離線編譯和優化,包括算子 和層的融合及重排運算順序。

• 用於語音分析的語音和音訊 管 道。

邊緣處理SoC包含多個處理 元件,包括一種或多種上述類型。 這些處理元件可以單獨使用或一 起使用,在邊緣執行機器學習。可 以設計各種優化的機器學習管道, 以有效利用SoC的可用處理能力。 邊緣機器學習運算是一項系統級 優化工作,需要正確使用並啟用 SoC上的多個處理元件,以支援 先進的即時邊緣機器學習處理。

用於異常檢測的序列資料處 理管道處理管道和靈活的軟體架 構提供開箱即用的,針對SoC和 應用類型優化過的運作時支援。 這有助於完全利用異質SoC功能 實現機器學習,並最大限度提高組 件的重複利用,這種方法的主要優 勢包括改善開箱即用體驗(OOBE) 和易用性。

針對邊緣設備優化機器學習 管道

圖4考慮了對基於影像資料的 智慧(工業檢測、人臉/人物/物件檢 測與分類及動作識別)不斷成長的 需求。這種智慧推動了視覺快速 整合基於機器學習的技術,基於 手動特徵提取與使用的傳統視覺 技術仍在大量使用,但是強大的 運作推理引擎硬體的出現,結合 廣泛可用的機器學習框架和基於

嵌入式邊緣設備正變得越來 越複雜,功能也越來越強大,因 為它們整合了更多硬體元件(例如

CPU、GPU、DSP和機器學習加速 器)來執行各種形式的機器學習。 然而,這些複雜的硬體元件必須 得到有效利用。帶有GPU和NPU 等專用加速器的邊緣設備執行矩 陣乘法的速度明顯高於CPU,機 器學習框架可以有效地利用這些 硬體元件。支援機器學習的軟體 架構可以優化機器學習在SoC中 的執行流程,以提供高性能、低功 耗的解決方案。

特定應用的處理管道分多個 階段進行設計,可以充分利用管道 中的多步驟進行機器學習處理,主 要應用領域包括: