Page 23 - 企業轉型腳步不停歇2022年數位優先世界成形

P. 23

INDUSTRY TRENDS

定工作負載進行成本最佳化。」 Lacey表示,Graphcore的 IPU設計是經過深思熟慮,把應 用邏輯放在加速器上;主處理器 和加速器之間的連結只用於訓練 資料──他強調,沒有程式碼、沒

也提供了相應地重新配置主CPU 數量的彈性。

放(weak scaling)上呈現類似的 結果(弱縮放並未包括在MLPref 的跑分結果中)。

有繁重的同步,只有資料。 另一個議題是,減少CPU的 數量是根據工作負載以及工作負 載使用的資料來決定。Lacey指 出:「它是依據需要多少準備,或 是有多少其他非AI類型的任務需 要在CPU上完成;還有在CPU和

Graphcore比較了主CPU和 加速器數量的比例,是以單一顆 Graphcore晶片對Nvidia晶片 或Habana晶片為基礎。如果單 一Graphcore IPU-Pod16等同 於單一的Nvidia DGX-A100,當 Graphcore尋求ResNet-50訓練 時間比較,就需要同樣數目的主 CPU (但在這個例子中任何優勢 只針對BERT)。

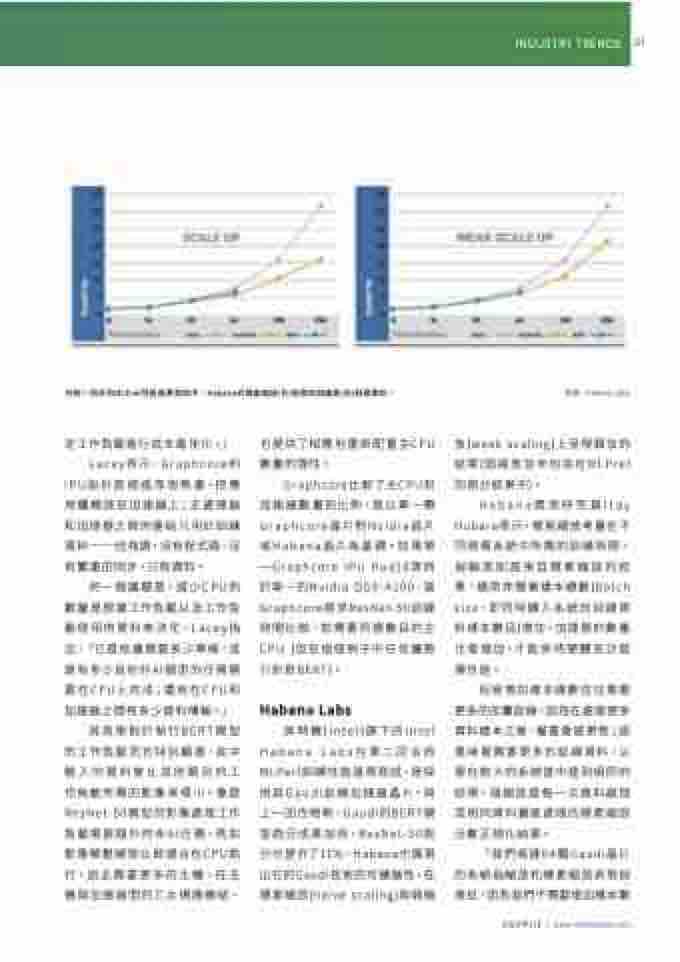

英特爾(Intel)旗下的Intel Habana Labs在第二回合的 MLPerf訓練性能基準測試,是採 用其Gaudi訓練加速器晶片。與 上一回合相較,Gaudi的BERT模 型跑分成果加倍,ResNet-50跑 分也提升了11%。Habana也展現 出它的Gaudi技術的可擴展性,在 樸素縮放(naïve scaling)與弱縮

Habana資深研究員Itay Hubara表示,樸素縮放考量在不 同規模系統中所需的訓練時間, 弱縮放則是來自樸素縮放的結 果。通常伴隨著樣本總數(batch size,即同時饋入系統的訓練資 料樣本數目)增加,加速器的數量 也會增加,才能保持硬體充分發 揮性能。

加速器之間有多少資料傳輸。」 其效果對於執行BERT模型 的工作負載而言特別顯著,其中 輸入的資料會比其他類別的工 作負載所需的影像來得小。像是 ResNet-50模型的影像處理工作 負載需要額外的非AI任務,例如 影像解壓縮就比較適合在CPU執 行,因此需要更多的主機。在主 機與加速器間的乙太網路連結,

Habana Labs

但是增加樣本總數往往需要 更多的反覆訓練,因為在處理更多 資料樣本之後,權重會被更新;這 意味著需要更多的訓練資料,以 便在較大的系統當中達到相同的 結果。弱縮放是每一次資料處理 或相同資料量被處理的樸素縮放 分數正規化結果。

「我們高達64顆Gaudi晶片 的系統弱縮放和樸素縮放表現很 接近,因為我們不需要增加樣本數

2022年1月 | www.eettaiwan.com

21

在每一回合的MLPref性能基準測試中,Habana的樸素縮放(左)結果與弱縮放(右)結果類似。

(來源:Habana Labs)